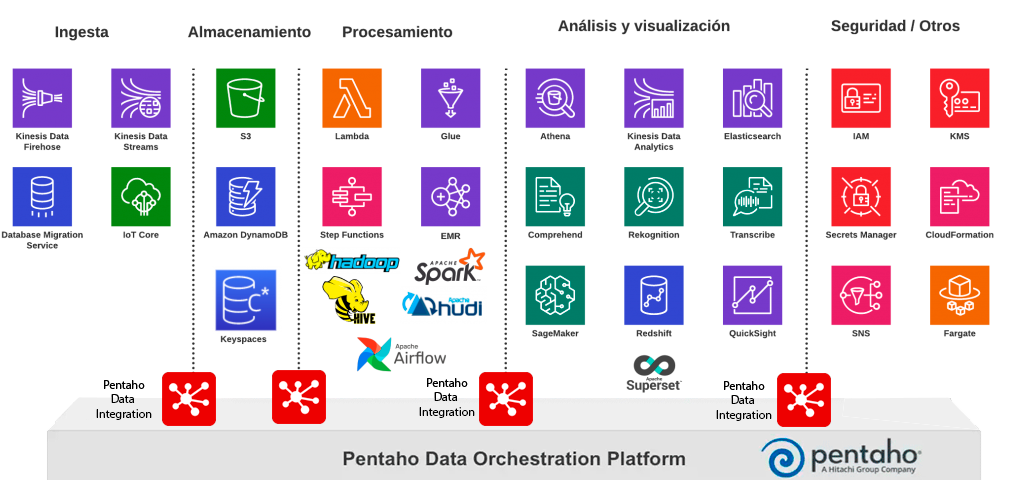

Ingestión de Data Big Data

Sin ingestión de datos no hay Big ni Data. Es una de las fases más importantes de todo un proyecto Big Data. Saber diseñar las formas de ingestión y usar adecuadamente el set de tecnologías que los desarrolladores tienen a su disposición es nuestro objetivo.

Procesamiento Batch Big Data

El procesamiento Batch es uno de los recursos más utilizados en proyectos Big Data. Para «comprimir» los datos y generar estadísticas o entrenar algoritmos es necesario procesar TODO el histórico. En PentaDemy proponemos las mejores tecnologías que actualmente se están demandando en el sector y se enseña al alumno aquellas buenas prácticas para poder enfocar bien los proyectos y hacer un desarrollo con éxito

Procesamiento REAL TIME Big Data

Procesar los datos en «Real Time» o «Near Real Time» es de suma importancia. Aplicar algoritmos de Machine Learning en los datos conforme se van generando es uno de los casos de uso más típicos en las empresas que buscan inmediatez. En PentaDemy proponemos tecnologías como Storm, Kafka, Spark Streamming, Flink y otras para dar una visión profunda y actual de los proyectos Big Data

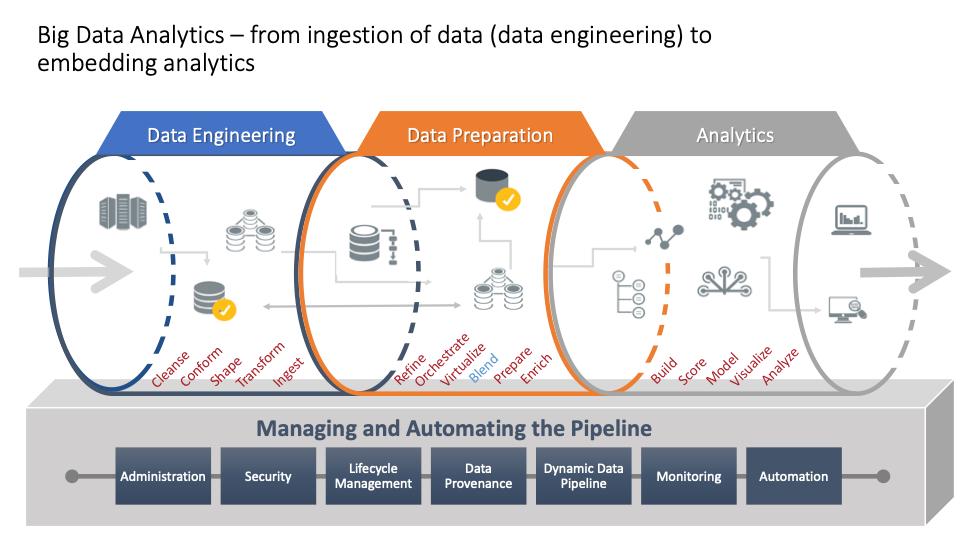

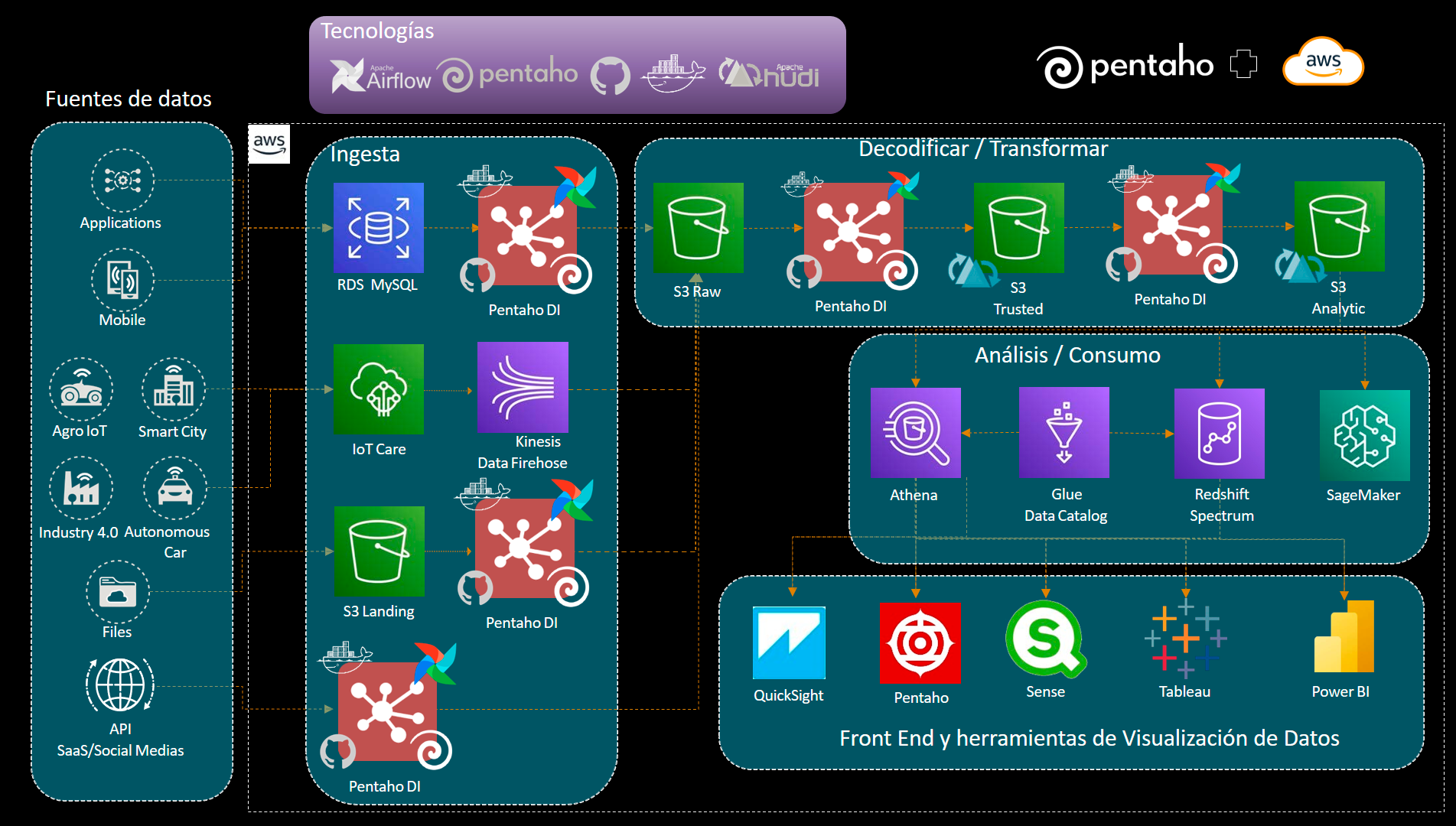

Arquitectura Big Data

Diseñar bien o elegir bien las herramientas que conforman un cluster Big Data es complicado. Son innumerables factores como el presupuesto, la tecnología Opensource vs Propietaria, etc. En PentaDemy proponemos cursos para que los profesionales puedan asentar conocimientos y tomar mejores decisiones, tanto en la arquitectura tecnológica como en el desarrollo y gestión de proyectos