La ruta más completa en Data Enginner

Accede ya y conviertete en un experto en la ingeniería de datos

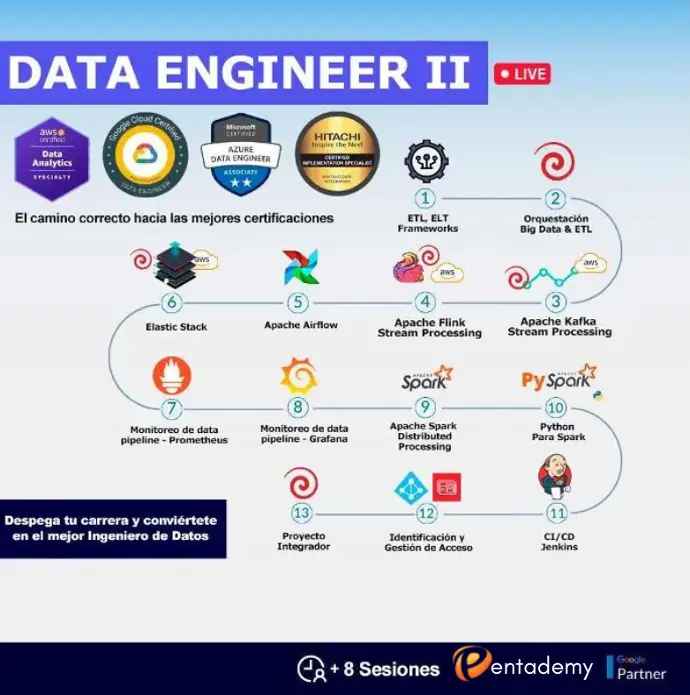

DATA ENGINEER I - FUNDAMENTALS

En este programa, el participante adquiere las habilidades que le permiten comprender y desplegar el ecosistema de Hadoop on-premise, es decir en su propia infraestructura, utilizando tecnologías de virtualización como docker y kubernete, e identifica plenamente como dicho ecosistema está desplegado en los principales. proveedores cloud: AWS, Azure y GCP, utilizando para ello, los principales servicios auto-gestionados, estando así en la capacidad de satisfacer la demanda creciente del mercado, en relación a contar con profesionales con conocimientos en entornos Híbridos de Big Data (on- presmise & on-cloud), así mismo el participante aprende el lenguaje de programación Python requerido en el contexto de proyectos de Big Data para transformar los datos de formatos crudos (RAW) a estructura formatosdos.

Por otro lado, se sientan las bases para que el participante comprenda como se debe llevar el control de versiones a lo largo del ciclo de vida del desarrollo, puesto en práctica en los diversos laboratorios del programa.

Por último, se revisan las principales tecnologías de bases de datos SQL y NoSQL en entornos cloud, brindándose los fundamentos para la gestión de tormentas de datos o transmisión de datos en tiempo real y/o casi en tiempo real. En este punto el participante ya es capaz de comprender las diversas tecnologías de tipo API's, así como el consumo de las mismas como parte del desarrollo en sus algoritmos.

Presentación Ruta Hybrid Cloud

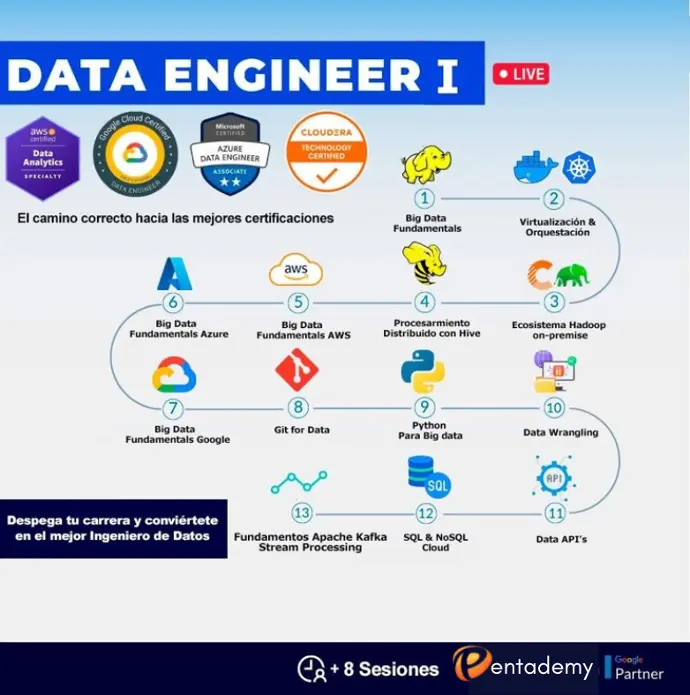

DATA ENGINEER II - ORQUESTACIÓN

En el programa de Data Engineer II, el participante adquiere las habilidades cognitivas que le permiten entender, diseñar y desarrollar según sea el caso procesos ETL y/o ELT, siendo capaz de identificar los principales frameworks ETL/ELT, formándose en el uso aplicado de Pentaho Data Integration (PDI), la cual forma parte de la suite de analítica provista por la compañía japonesa HITACHI, esto le permitirá desarrollar casos de uso y pruebas de concepto para el tratamiento de datos por streaming en tiempo real y/o casi en tiempo real. , todo ello con el despliegue de clusters con Apache Kafka y Apache Flink.

Sumado a lo anterior el participante será capaz de desarrollar ETL's empleando Elastic Stack, atendiendo así el procesamiento en streaming, de tormenta de datos. Aprenderá también a gestionar flujos de actividades utilizando Apache Airflow.

Para monitorear los diversos procesos y flujos de data pipelines, utilizará Prometeus junto a Grafana. En este punto el participante se sumerge en el procesamiento de datos por streaming con Spark y Python (PySpark).

En la línea de la integración continua y el despacho continuo (CI/CD), se emplea Jenkins y para la gestión e identificación de acceso se utilizan herramientas Cloud en AWS y Azure. El curso termina con el desarrollo y despliegue del proyecto integrador.

Accede a la ruta más completa

Data Engineer